Spark,你值得拥有

1、SparkStreaming工作原理2、SparkStreaming编写步骤 3、SparkStreaming消费Kafka中数据的两种方式? ……

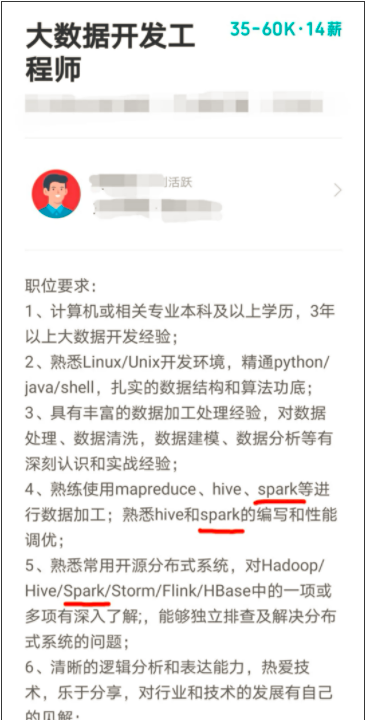

大数据火了,连带着大数据的面试题也升级了,不积累一些高频面试知识点在一面就会被秒成渣。但凡和大数据挂钩的,Spark是必不可少的技能要求,不信,你看看这些动不动就35K、60K的高薪岗位,Spark出现的频率。

SparkStreaming是Spark核心API的一个扩展,可以实现高吞吐量,具备容错机制的实时流数据处理能力。SparkStreaming接收Kafka、Flume、HDFS等各种来源的实时输入数据,进行处理后,处理结构保存在HDFS、DataBase等各种地方。

SparkStreaming使Spark拥有了流计算能力,对于各大企业处理实时任务来说,是绝对的香!

可是想要自学达到精通SparkStreaming,进而能够胜任企业岗位简直太难了!初学者往往一头雾水,有基础的在细节问题上也常常不知道如何下手,而通过度娘能解决的又实在有限,找别人请教也没办法形成体系化认知。

想要在这个高薪领域中分得一杯羹,今天我给大家支个招儿,短期突击+持续学习是程序员的制胜法宝。来自南通东方标准的《大数据企业级实战》课程特别推荐给你,帮助你尽早积累项目经验,缩短职场晋升周期。